En SEO, optimiser les pages où les visiteurs doivent aller est la règle d’or. Il faut donc faire en sorte que les moteurs passent plus de temps sur les pages importantes que sur les autres, et pour savoir ce que fait rééllement le robot, il n’y a qu’une méthode: c’est l’analyse des logs serveurs.

Surveiller le crawling des robots permet de bien comprendre ce que voit le robot (par ex des pages 404), et où il passe le plus clair de son temps (page d’accueil ou pages profondes).

Il y a plusieurs méthodes pour surveiller le crawling:

– récupérer les logs d’Apache, puis les passer dans une moulinette sur son serveur comme la Watussibox.

– récupérer les logs d’Apache, puis les envoyer à un service comme Botify.

– traiter en temps réél le crawl des bots depuis Analytics.

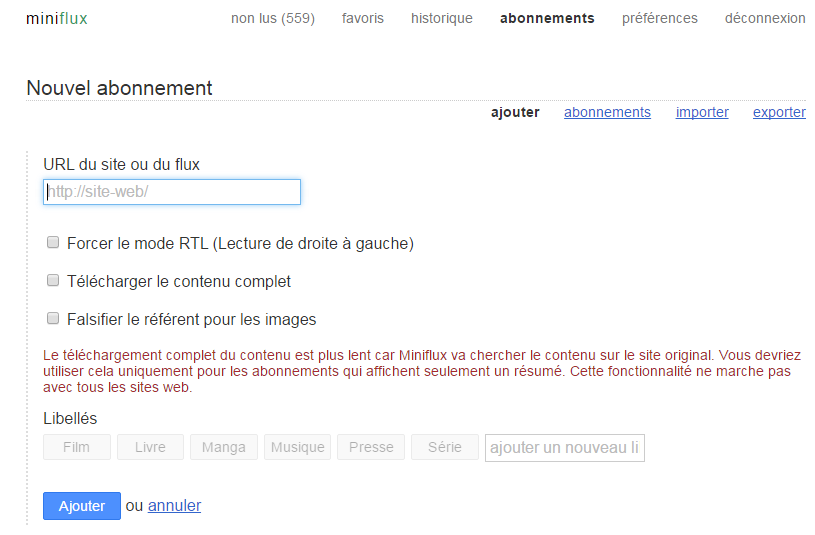

C’est cette dernière méthode que j’ai choisi. Pour cela, j’ai créé un plugin WordPress qui se charge d’analyser le UserAgent et qui s’il s’agit d’un bot ou d’un crawler se charge de renvoyer les informations sur Analytics sur un profil dédié (pensez à créér un UA spécifique et à le renseigner dans le tableau de bord du plugin WordPress).

Le plugin wordpress d’analyse de crawl est disponible ici.

Dites-moi dans les commentaires ce que vous en pensez.

Bonjour,

J’ai bien installé le pluggin sur mon blog mais je ne comprend pas comment créer une UA sur Analytique ? et comment voir les résultats ?

Merci

Bonjour,

Ce plugin est-il toujours fonctionnel ou maintenu ?

Quoiqu’il en soit l’initiative est plus qu’intéressante.

Merci de votre réponse (en commentaire ou en message privé).

Julien de NetWash.

Bonjour, meme si ca date, il devrait toujours fonctionner car le user agent de google n’a pas changé.